En el siglo XXI por el aumento drástico de informaciones, necesitamos algunas técnicas como web scraping para categorizar y limpiar datos. Las empresas compiten entre sí con información masiva recopilada de una multitud de usuarios, ya sea por sus comportamientos de consumo, o contenido compartido en las redes sociales.

Muchas empresas e industrias siguen siendo novatos en el ámbito de los datos. Entre las empresas basadas en datos, solo un bajo porcentaje ha logrado cierto éxito. Una de las razones principales se debe a la comprensión mínima de la tecnología de datos o su falta de habilidades de programación.

Puede usar Python, Selenium y PHP para raspar los sitios web si es experto en programación. Pero para los usuarios normales que tienen necesidades de datos pero no versados en la programación, el software de raspado web es una clave esencial para el establecimiento de una estrategia comercial basada en datos. En este artículo, discutimos el uso de web scraping tools para facilitar el scraping sin esfuerzo.

Raspado de Datos en la Era Informática

Algunas herramientas de web scraping, como Octoparse, proporcionan plantillas y servicios de scraping que son una gran ventaja para las empresas que carecen de habilidades de scraping de datos, o que quieren ahorrar tiempo en el scraping de la web. Algunas de las herramientas de web scraping requieren que tenga algunas habilidades de programación para configurar un raspado avanzado, por ejemplo, Apify. Por lo tanto, realmente depende de lo que desea raspar y de los resultados que desea lograr.

Primero, intente pasar un tiempo para estudiar sitios web específicos. Esto no significa que deba analizar la página web. Basta con echar un vistazo a las páginas web. Al menos debe saber cuántas páginas necesita scrapear.

En segundo lugar, preste atención a su estructura HTML. Algunos sitios web no están escritos de manera estándar. Dicho esto, si necesita raspar el contenido de un sitio web de estructura HTML mal organizada, debería modificar el XPath.

Tercero, encuentre la herramienta correcta. A continuación, le dejo aquí una lista de recomendació de herramientas de web scraping. Espero que pueda proporcionarle algunas ideas.

10 Herramientas de Web Scraping

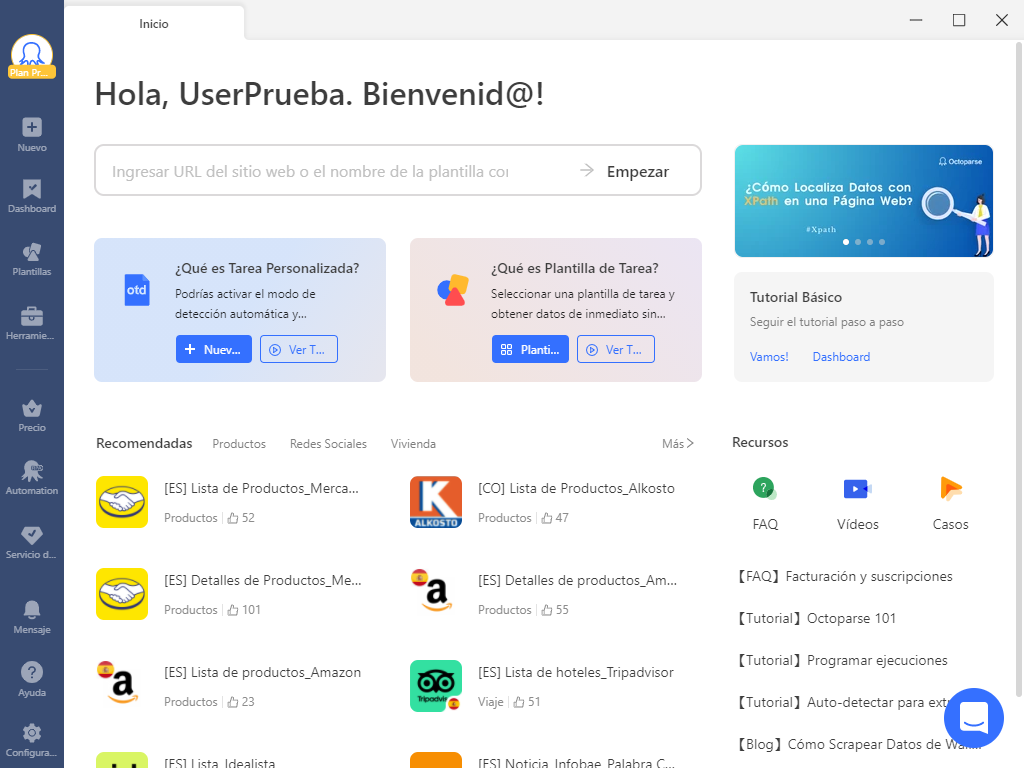

#1 Octoparse

Octoparse es un web scraper gratuito y potente con funciones integrales. ¡Con el plan gratuito puede descargar hasta 10.000 de datos! Octoparse diseña el proceso de extracción de datos simulando el scraping humano, y como resultado, todo el proceso de scraping es fácil de entender y operar. Es una buena opción si no tiene idea de la programación. Puede usar las herramientas Regex y XPath para tener una extracción más precisa.

Para facilitar a lo máximo la extracción de datos para los usuarios, Octoparse además según los sitios web más populares prediseñaron más de 300 plantillas integradas así que con solo ingresar palabras clave o URL, pueden descargar datos de páginas web como de Amazon, Twitter, Google Maos y TripAdvisor. Si necesita personalizar la extracción, también puede utilizar el modo avanzado configurando una tarea con la detección automática o manualmente. Los datos raspados se exportarán a Excel, HTML, CVS, Json, Google Sheets o a su base de datos.

Pros: plantillas de tareas integradas, rastreos ilimitados gratuitos, modo de detección automática, extracción, descarga de imágenes rápida, herramientas Regex y Xpath y tutoriales y equipo de soporte gratuitos.

Contras: Desafortunadamente, Octoparse aún no tiene la función de extracción de datos PDF.

#2 Mozenda

Mozenda es un servicio de web scraping basado en la nube. Incluye una consola web y un generador de agentes que le permite ejecutar sus propios agentes, ver y organizar resultados. También le permite exportar o publicar datos extraídos a un proveedor de almacenamiento en la nube como Dropbox, Amazon S3 o Microsoft Azure. La extracción de datos se procesa en servidores de recolección optimizados en los centros de datos de Mozenda. Como resultado, esto aprovechando el recurso local del usuario evitará que sus direcciones IP sean prohibidas.

Pros: Mozenda proporciona una barra de acción integral, que es muy fácil de capturar datos AJAX e iFrames. También es compatible con la extracción de documentación y extracción de imágenes. Además de la extracción multiproceso y la agregación inteligente de datos, Mozenda proporciona Geolocation para evitar la prohibición de IP, y el modo de prueba y el manejo de errores para corregir errores.

Contras: Mozenda es un poco caro, que cobra desde $ 99 por 5000 páginas. Además, Mozenda requiere una PC con Windows para ejecutarse y tiene problemas de inestabilidad cuando se trata de sitios web extra grandes.

#3 80legs

80legs es una poderosa herramienta de rastreo web que se puede configurar según los requisitos personalizados. Es interesante que pueda personalizar su aplicación para scrape y rastrear, pero si no es una persona de tecnología, debe tener cuidado. Asegúrese de saber lo que está haciendo en cada paso cuando personalice su raspado. 80legs admite la obtención de grandes cantidades de datos junto con la opción de descargar los datos extraídos al instante. Y es muy bueno que pueda rastrear hasta 10000 URL por ejecución en el plan gratuito.

Pros: 80legs hace que la tecnología de web crawling sea más accesible para empresas y personas con un presupuesto limitado.

Contras: si desea obtener una gran cantidad de datos, deberá establecer un crawl y una API preconstruida. El equipo de soporte es lento.

#4 Import.Io

Import.Io es una plataforma de web scraping que admite la mayoría de los sistemas operativos. Tiene una interfaz fácil amigable que es fácil de dominar sin escribir ningún código. Puede hacer clic y extraer cualquier dato que aparezca en la página web. Los datos se almacenarán en su servicio en la nube durante días. Es una opción para los usuarios empresarios.

Pros: Import.io es fácil de usar y admite casi todos los sistemas mientras que con Import.io puede realizar la mayoría de sus proyectos de datos.

Contras: El plan gratuito ya no está disponible. Cada subpágina cuesta crédito. Puede volverse costoso si extrae datos de varias subpáginas. El plan pagado cuesta $299 por mes por 5000 consultas URL o $4,999 por año por medio millón de resultados.

#5 Content Grabber

Content Grabber es una poderosa herramienta de raspado visual de múltiples funciones para la extracción de contenido de la web. Puede recopilar automáticamente estructuras de contenido completas, como catálogos de productos o resultados de búsqueda. Para las personas con grandes habilidades de programación pueden encontrar una forma más efectiva a través de Visual Studio 2013 integrado en Content Grabber. Content Grabber ofrece más opciones para usuarios con herramientas de terceros.

Pros: Content Grabber es flexible en el manejo de sitios web complejos y extracción de datos. Le ofrece el privilegio de editar la adaptación de raspado a sus necesidades.

Contras: el software solo está disponible en sistemas Windows y Linux. Para principiantes, su alta flexibilidad puede no ser una buena ventaja por la complejidad de operación atraída. Además, no tiene una versión gratuita. El precio perpetuo es de $995, lo que hace que los usuarios de pequeños proyectos con presupuestos limitados necesite tomarlo en consideración.

#6 Outwit Hub

Outwit Hub es una de las herramientas de web scraping más simples, que es de uso gratuito y le ofrece la conveniencia de extraer datos web sin escribir ninguna línea de código. Tiene tanto la extensión Firefox como la aplicación de escritorio. Su interfaz simple es fácil de usar para principiantes.

Pros: El “Fast Scrape” es una característica muy agradable que puede scrape rápidamente los datos de la lista de URL que proporciona.

Contras: La extracción de datos web básica no incluyen características avanzadas como la rotación de IP y CAPTCHAs bypassing. Sin la rotación de IP y la omisión de CAPTCHA, su tarea de raspado puede fallar al completarse. Debido a que se detectará fácilmente un alto volumen de extracción, los sitios web lo obligarán a detenerse y evitarán que tome medidas.

#7 Parsehub

ParseHub es una aplicación de escritorio. A diferencia de otras aplicaciones de web crawling, ParseHub es compatible con la mayoría de los sistemas operativos como Windows, Mac OS X y LINUX. Además, tiene una extensión de navegador que le permite raspar instantáneamente. Puede scrapeat ventanas emergentes, mapas, comentarios e imágenes. Los tutoriales están bien documentados, lo que definitivamente es una gran ventaja para los nuevos usuarios.

Pros: Parsehub es más fácil de usar para programadores con acceso a API. Es compatible con más sistemas en comparación con Octoparse. Y también es flexible para raspar datos en línea con diferentes necesidades.

Contras: el plan gratuito es dolorosamente limitado en términos de páginas raspadas y proyectos con solo 5 proyectos y 200 páginas por ejecución. Su plan pagado es costoso, de $149 a $ 499 por mes. Los raspados de gran volumen pueden ralentizar el proceso de raspado. Por lo tanto, los proyectos pequeños encajan bien en Parsehub.

#8 Apify

Apify es una interesante plataforma de web scraping para codificadores. Si tiene habilidades básicas de codificación, puede intentarlo. No tiene una función de hacer clic y extraer. En su lugar, deberá escribir JavaScript para decirle al rastreador lo que desea extraer.

Pros: el lado bueno de esto es que puede manejar páginas web con estructuras irregulares. Tiene integración JQuery, que es una biblioteca JavaScript de código abierto. La versión gratuita permite crawling hasta 5000 por mes.

Contras: el inconveniente es bastante obvio, para la mayoría de las personas que no tienen habilidades de programación, que es muy difícil de usar. El precio para un desarrollador es gratuito, pero para un usuario normal, el precio se establece entre $49 por mes y $499 por mes. Y tiene un corto período de retención de datos, así que no olvídese de guardar los datos extraídos a tiempo si prueba Apify.

#9 Scrapinghub

Scrapinghub es una plataforma web basada en la nube. Tiene cuatro diferentes tipos de herramientas: Scrapy Cloud, Portia, Crawlera y Splash. Es genial que Scrapinghub ofrezca una colección de direcciones IP cubiertas en más de 50 países, que es una solución para los problemas de prohibición de IP.

Pros: Scrapinghub ofrece varios servicios web para diferentes proyectos de datos, incluido el framework de código abierto Scrapy y la herramienta de raspado de datos visual Portia.

Contras: Scrapy está disponible para programadores. Portia no es fácil de usar y necesitará agregar complementos si desea lidiar con sitios web complejos.

#10 Dexi.io

Dexi.Io es un rastreador web basado en navegador. Proporciona tres tipos de robots: extractor, rastreador y tuberías (PIPES). PIPES tiene una función de robot maestro donde 1 robot puede controlar múltiples tareas. Admite muchos servicios de terceros (solucionadores de captcha, almacenamiento en la nube, etc.) que puede integrar fácilmente en sus robots.

Pros: Los servicios de terceros son definitivamente una gran ventaja en comparación con otras herramientas de web scraping. El gran equipo de soporte le ayudará a construir su propio robot.

Contras: El precio es relativamente más alta, que oscila entre $119 por mes y $699 por mes, dependiendo de su capacidad de rastreo y la cantidad de robots en funcionamiento. Además, es bastante complicado entender el flujo si no tiene conocimientos de programación.

Conclusión

Hoy en día, con el rapidísimo desarrollo de la IA y el big data, cada vez aparecen más herramientas de procesamiento de datos. Antes de elegir una, es necesario determinar: la frecuencia de recopilación de datos (diaria/semanal), el número de entradas recopiladas (miles/decenas de miles), el tipo de páginas recopiladas, etc. Elegir la herramienta adecuada a menudo permite obtener el doble de resultados con la mitad de esfuerzo.

La recogida de datos de Octoparse es completamente gratuita, y tiene formas más flexibles de adquirir datos, por lo que una vez que aprenda a trabajar, obtendrá todos los datos que desee.

Convetir datos de sitios web en Excel, CSV, Google Sheets y base de datos directamente.

Scrapear datos fácilmente con funciones de Auto-Detectar, sin codificación.

Plantillas de crawler preestablecidas para sitios web populares para obtener datos en clics.

Nunca se bloquee con proxies IP y API avanzada.

Servicio en la Nube para programar la recopilación de datos en cualquier momento que desee.