Big data es un término que describe conjunto de datos grandes tanto estructurados como no estructurados. Estos datos son tan voluminosos y rápidos que hacen que sea difícil de administrar y extraer con una tradicional herramienta de análisis de datos, por ejemplo con python.

Big Data tiene como objetivo resolver preguntas previamente sin respuesta aprovechando las nuevas tecnologías como la inteligencia artificial, el aprendizaje automático, etc. Para las empresas, los datos que inundan en su base de datos de día al día son minas de oro para nuevos comentarios del mercado que lo llevarán al nivel superior.

Sin duda, existen numerosas formas de implementar la recopilación de datos para formar las bases de todos los trabajos futuros. Cada herramienta de extracción de datos tiene sus contras y ventajas mientras comparten algo en común.

En las siguientes partes, puede aprender los 5 pasos explicados sobre cómo recopilar big data y la mejor herramienta de recopilación de datos para ayudarle a extraer datos sin codificación.

5 Pasos para Recopilar datos como Big Data

Los datos sin procesar y aleatorios son un tesoro que queda por explorar. Ordenando y estructurando big data y limpiando las partes no deseadas, se crea un gran valor practicable para las empresas.

Paso 1: Recopilar los datos

Hay muchas maneras de recoger datos según diferentes propósitos. Por ejemplo, puede comprar datos de empresas de Datos-como-Servicio (Daas) o utilizar una herramienta para compilar datos de sitios web.

Paso 2: Almacenar los datos

Después de recopilar los datos, puede ponerlos en las bases de datos o almacenarlos para su procesamiento superior. Por lo general, este paso requiere inversión en servidores físicos, así como en servicios en la nube. Algunas herramientas de recogida de datos vienen con almacenamiento en la nube después de que se coleccionan los datos, lo que ahorra los recursos locales en gran medida y facilita el acceso a los datos desde cualquier lugar.

Paso 3: Limpiar los datos

La limpieza de datos es importante para un análisis eficaz de datos. Dado que habría información innecesaria, debería elegir la que corresponde a sus necesidades. Este paso consiste en ordenar los datos, incluida la limpieza, la concatenación y la fusión de los datos.

Paso 4: Reorganizar los datos

Se necesitaría reorganizar los datos después de limpiarlos para uso posterior. Por lo común, convirtiendo los formatos no estructurados o semi-estructurados en formatos estructurados como Hadoop y HDFS.

Paso 5: Verificar los datos

Para asegurarse de que los datos que obtiene son correctos y significativos, debería verificar los datos. Pruébelos con muestras de datos para ver si funcionan. Asegúrese de que está en la dirección correcta para que pueda aplicar estas técnicas a administrar sus datos de origen.

Mejor Herramienta de Recopilación de Big Data

Arriba están los cinco pasos generales para recopilar los datos necesarios para el análisis de big data. Sin embargo, coleccionar datos, analizarlos y obtener informaciones sobre los mercados no es un proceso fácil si lo hacen sin ayuda.

Por eso, es mejor utilizar herramientas de recopilación de datos como Octoparse, para ayudarnos a obtener los datos que queremos, ya que facilitará mucho este proceso.

La mayoría de las herramientas de extracción de datos pueden ayudar a recoger una gran cantidad de datos en poco tiempo y permiten a los usuarios compilar datos ordenados y estructurados automáticamente para que no haya necesidad de ordenarlos o reorganizarlos manualmente, especialmente Octoparse. Es una herramienta de web scraping simple y gratuita pero poderosa que automatiza la extracción de datos web, lo que le permite crear crawler de extracción de alta precisión con solo clics. Los rastreadores que se ejecutan en Octoparse están determinados por las reglas configuradas. Estas reglas guiarán a Octoparse para obtener los datos que desea.

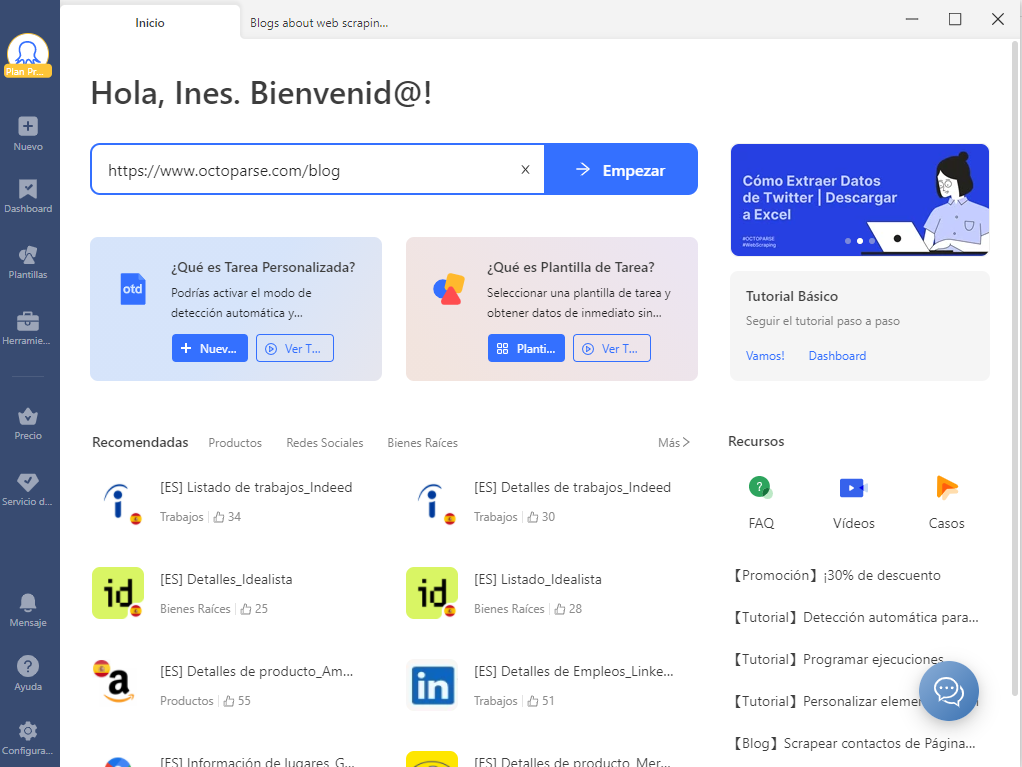

Octoparse tiene dos modos de extracción (Plantilla de Tarea y Modo Avanzado) para extraer datos. Proporciona más de 300 plantillas prediseñadas para los usuarios y sería genial si hay plantillas que se ajusten a sus requisitos de datos.

Si no puede encontrar plantillas adecuadas, el simple y rápido modo de detección automática también puede ayudarle a recopilar datos fácilmente sin codificación. Cuando se hayan recopilado los datos, se podría almacenar en bases de datos en la nube, a las que se puede acceder en cualquier momento y de cualquier lugar. Los datos también se pueden exportar en Excel, CSV, HTML, etc.

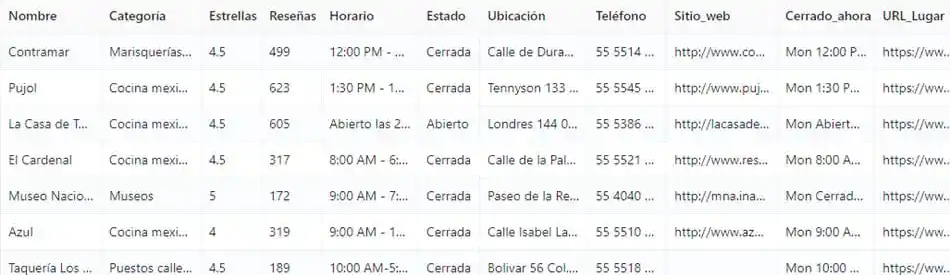

Ahora, vamos a ver un ejemplo de extracción con Octoparse para ayudarle a comprender mejor cómo le ayuda esta herramienta a extraer los datos que necesita. Tomaremos la plantilla de Yelp como ejemplo aquí. Este scraper puede coleccionar información comercial como el nombre de la tienda, el número de teléfono, la ubicación, las reseñas, etc. Si quiere recopilar datos mediante la personalización de un rastreador web, podrías consultar los tutoriales básicos.

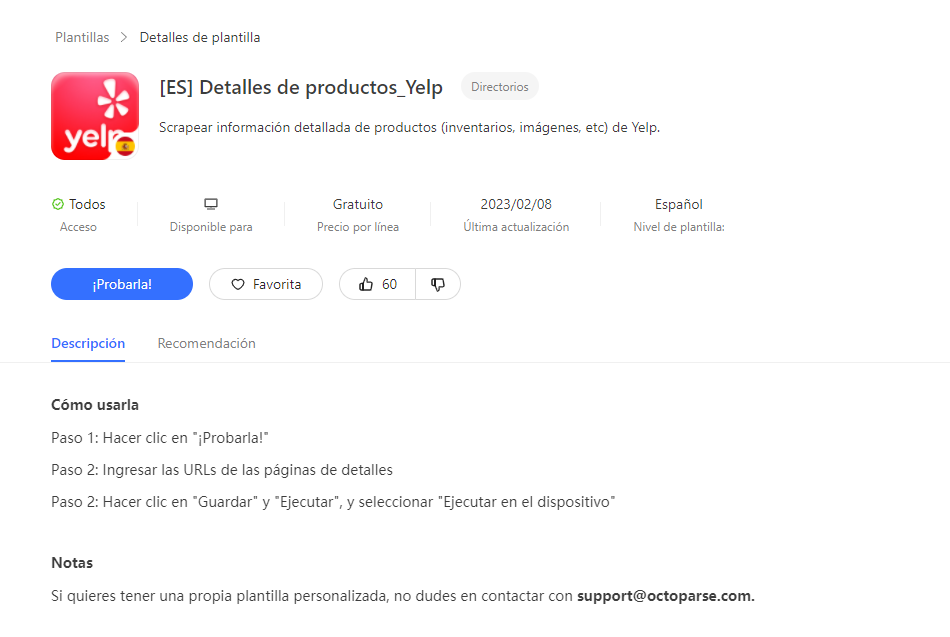

Paso 1: Encontrar la plantilla [ES] Detalles de productos_ Yelp

Es fácil ver la plantilla de Yelp scraper en la página de inicio del software. Haga clic en ella y verá todas las plantillas de Yelp que tenemos; vamos a seleccionar la plantilla que necesitamos.

Paso 2: Ingresar los parámetros en su scraper

Haga clic en la plantilla de scraper, verá una breve guía de para qué sirve esta plantilla específica, cómo usarla, qué tipo de parámetros debería ingresar y qué datos puede obtener.

Ahora usted es el comandante para ordenar lo que hará su Yelp scraper para usted. Suele haber cuatro tipos de parámetros que debe rellenar:

Palabras clave – Qué tipo de datos empresariales desea scrapear

Cantidad de las páginas – Cuántas páginas de datos necesita scrapear, ej. 10

Ubicaciones – La ubicación que le gustaría buscar, ej. Nueva York

URL – Los enlaces por donde se extraerán los datos

Y en esta plantilla, el parámetro que necesitaremos ingresar son URLs.

Paso 3: Ejecutar el scraper y exportar el dato cuando se complete

Al terminar la configuración, haga clic en Ejecutar y Guardar. Esta plantilla particular de Yelp solo se puede ejecutar en la Nube, por lo que el scraper logre scrapear con la rotación de IP y evitar su bloqueo. Ahora, eche un vistazo a ¨Dashboard¨ y encontrará todos los scrapers (tareas) que ha construido y verá si termine la tarea. Si aún no ha utilizado las herramientas de extracción de datos, pruébelo ahora gratuitamente.