Un scraper idealista de redes sociales a menudo se refiere a una herramienta de web scraping automática que extrae datos de una web. No solo incluye sitios de redes sociales, como Facebook, Twitter, Instagram, LinkedIn … etc., sino que también incluye blogs, wikis y sitios de noticias. Todos estos portales comparten algo en común: todos están generando contenido generado por el usuario en forma de datos no estructurados a los que solo se puede acceder a través de la web.

Ahora que conocemos la definición del scraper de redes sociales, voy a ilustrar más a fondo cómo se puede usar el conjunto de datos de redes sociales en los negocios y enumeraré las 5 mejores de web scraper de redes sociales que recomiendo.

¿Qué puedes hacer con los datos raspados de las redes sociales?

Los datos extraídos de las redes sociales son, sin duda, el conjunto de datos más grande y dinámico sobre el comportamiento humano. Ofrece a los científicos sociales y expertos en negocios nuevas oportunidades para comprender a las personas, los grupos y la sociedad, así como a explorar la gran riqueza oculta en los datos.

Análisis de redes sociales: Una encuesta de técnicas, herramientas y plataformas señala que los primeros en adoptar negocios de análisis de datos de redes sociales son compañías típicas en las industrias minorista y financiera. que aplicaron análisis de redes sociales para aprovechar el conocimiento de la marca, la mejora del servicio al cliente y las estrategias de marketing. e incluso detección de fraude.

Además de las aplicaciones mencionadas anteriormente, hoy el conjunto de datos de redes sociales también se puede aplicar para:

- Medición del sentimiento del cliente

Después de recopilar las opiniones de los clientes de los canales de redes sociales, puede analizar la actitud del cliente hacia un tema o producto en particular midiendo su tono, contexto y sentimientos. El seguimiento del sentimiento del cliente le permite comprender la satisfacción general del cliente, la lealtad del cliente, así como su intención de participación. Proporciona información para sus campañas de marketing actuales y futuras.

- Segmentación del mercado objetivo

“Un mercado objetivo es un grupo de clientes (individuos, hogares u organizaciones), organice y apunte a estos clientes para diseñar, implementar y mantener una mezcla de marketing que se ajuste a este conjunto de necesidades y preferencias”, según se define en Wikipedia. Obtener y analizar el conjunto de datos de las redes sociales le permite saber a quién y cuándo comercializar sus productos o servicios. Identificar mercados más específicos lo ayuda a maximizar su retorno de la inversión en marketing.

- Monitoreo de marca en línea

El monitoreo de marca en línea no solo es escuchar la voz de sus clientes, sino también saber lo que dicen sus competidores, la prensa e incluso la industria KOL. No se trata solo de su producto o servicio, sino también desus servicios al cliente, proceso de ventas, compromiso social y cada punto de contacto donde los clientes interactúan con su marca.

- Identificar tendencias del mercado

Identificar las tendencias del mercado es fundamental para ajustar su estrategia comercial para mantener su negocio sincronizado con la dirección cambiante de la industria. Con la ayuda de herramientas de automatización de big data, el análisis de tendencias del mercado compara los datos de la industria durante un período de tiempo específico mediante el seguimiento de los influyentes de la industria y los comentarios publicados en las redes sociales.

Los 5 mejores rastreadors de redes sociales en el mercado

1. Octoparse

Como una de las mejores herramientas de web scraping gratis de página web en el mercado, Octoparse se desarrolló para los no codificadores a fin de acomodar los complicados trabajos de scrape de páginas web.

La versión actual proporciona una interfaz intuitiva de hacer clic y admite el manejo de desplazamiento infinito, autenticación de inicio de sesión, entrada de texto (para scrape resultados de búsqueda), así como la selección de menús desplegables. Los datos raspado se pueden exportar como Excel, JSON, HTML o a bases de datos. Si desea crear un raspador dinámico para exraer datos de una web dinámicos en tiempo real, Octoparse Cloud Extraction (plan pagado) funciona bien para obtener fuentes de datos dinámicos, ya que admite el programa de extracción tan frecuente como cada 1 minuto.

Para obtener datos externos de una web de redes sociales, Octoparse ya publicó muchos tutoriales elaborados, como scraping tweets de Twitter y extraer publicaciones de Instagram. Además, Octoparse ofrece un servicio de recopilación de datos que entrega los datos directamente a su biblioteca de S3. Si tiene poco tiempo, puede ser una buena alternativa a considerar.

2. Dexi.io

Como una aplicación basada en la web, Dexi.io es otra herramienta intuitiva de automatización de extraer para fines comerciales con un precio inicial de $ 119/mes. Dexi.io admite la creación de tres tipos de robots: extractor, crawler, Pipes.

Dexi.io requiere algunas habilidades de programación para dominar, Pero puede integrar servicios de terceros para resolver el problema del captcha, almacenamiento en la nube, análisis de texto (integración del servicio MonkeyLearn) e incluso con AWS, Google Drive, Google Sheets …

El Plugin (plan pagado) también es una característica revolucionaria de Dexi.io y la cantidad de Plugin sigue creciendo. A través de Plugin, puede desbloquear más funciones disponibles en Extractor y Pipes.

3. OutWit Hub

A diferencia de Octoparse y Dexi.io, Outwit Hub ofrece una interfaz gráfica de usuario simple, así como funciones sofisticadas de scraping y reconocimiento de estructura de datos. Outwit Hub comenzó como un plugin de Firefox y más tarde se convirtió en una aplicación descargable.

Sin necesidad de conocimientos previos de programación, OutWit Hub puede extraer y exportar enlaces, direcciones de correo electrónico, noticias RSS y tablas de datos a bases de datos Excel, CSV, HTML o SQL.

Outwit Hub tiene características sobresalientes de “Fast Scrape”, que borra rápidamente los datos de una lista de URL que ingresas. Sin embargo, para los principiantes,es posible que deba leer algunos tutoriales básicos y documentación debido a la falta de aplicaciones de hace-clic-interface.

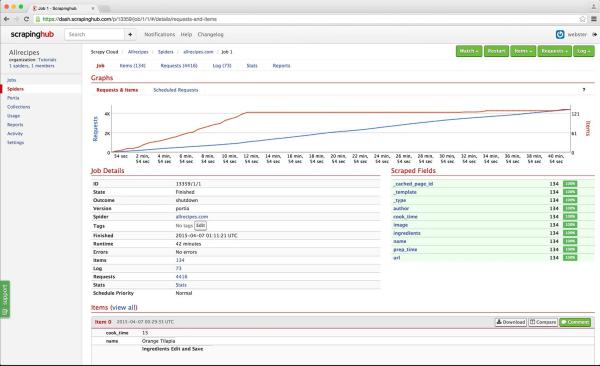

4. Scrapinghub(Zyte)

Scrapinghub es una plataforma de web scraping basada en la nube que le permite escalar sus rastreadores y ofrece un descargador inteligente para evitar contramedidas de bot, servicios de web scraping llave en mano y conjuntos de datos listos para usar.

La aplicación consta de 4 excelentes herramientas: Scrapy Cloud para implementar y ejecutar rastreadores web basados en Python; Portia es un software de código abierto para extraer datos sin codificación; Splash también es una herramienta de representación de JavaScript de código abierto para extraer datos de páginas web que usan JavaScript; Crawlera es una herramienta para evitar ser bloqueado por sitios web, por rastreadores desde múltiples ubicaciones e IP.

En lugar de proporcionar una suite completa, Scrapehub es una plataforma de web scraping técnicasbastante compleja y poderosa en el mercado, cada herramienta proporcionada por Scrapehub cuesta dinero por separado.

5. Parsehub

Parsehub es otro scraper de escritorio sin codificación en el mercado, compatible con Windows, Mac OS X y Linux. Ofrece una interfaz gráfica para seleccionar y extraer los datos de las páginas JavaScript y AJAX. Los datos se pueden extraer de comentarios anidados, mapas, imágenes, calendarios e incluso ventanas emergentes.

Además, Parsehub también tiene una extensión basada en navegador para iniciar su tarea de scraping instantáneamente. Los datos se pueden exportar como Excel, JSON o mediante API.

Lo controvertido de Parsehub tiene que ver con su precio. La versión paga de Parsehub comienza en $149 por mes, que es más alta que la mayoría de los productos de raspado en el mercado, es decir, el plan estándar de Octoparse solo cuesta $89 por mes por páginas ilimitadas por rastreo. Hay un plan gratuito, pero lamentablemente se limita a raspar 200 páginas y 5 trabajos de raspado.

Conclusión

Además de lo que pueden hacer las herramientas automáticas de web scraping, ahora muchos canales de redes sociales ahora ofrecen API pagas a usuarios, académicos, investigadores y organizaciones especiales como Thomson Reuters y Bloomberg en servicios de noticias, Twitter y Facebook en redes sociales.

Con el desarrollo creciente y próspero de la economía en línea, las redes sociales abren muchas oportunidades nuevas para que su negocio se destaque en su campo, al escuchar mejor a sus clientes y relacionarse con sus clientes actuales y potenciales de formas completamente nuevas.