A medida que se extienden las filosofías de la inteligencia artificial y el big data, es posible que necesite extraer datos de un gran número de enlaces. Extraer todas las direcciones de hipervínculos de la página web es lo primero y más importante en este término. Permite explorar cada URL para recopilar diversos elementos web, como imágenes, texto o enlaces dentro del hipervínculo, para su posterior análisis.

Un extractor de enlaces más inteligente puede hacer que el proceso de extracción sea más eficiente y contribuir al análisis SEO, el análisis de la competencia, la creación de contenidos y mucho más. Este post le presentará las TOP 10 herramientas de web scraping para extraer enlaces.

Las 10 Mejores Herramientas para Extraer URL

👉 Solución de Web Scraping

TOP 1: Octoparse (El extractor de enlaces MÁS FÁCIL)

Octoparse es una poderosa y gratuita herramienta de web scraping que le permite extraer HTML interno/externo y enlaces de diferentes ámbitos de etiquetas. Es una solución sin código para que cualquiera pueda extraer datos sin escribir ninguna línea de código.

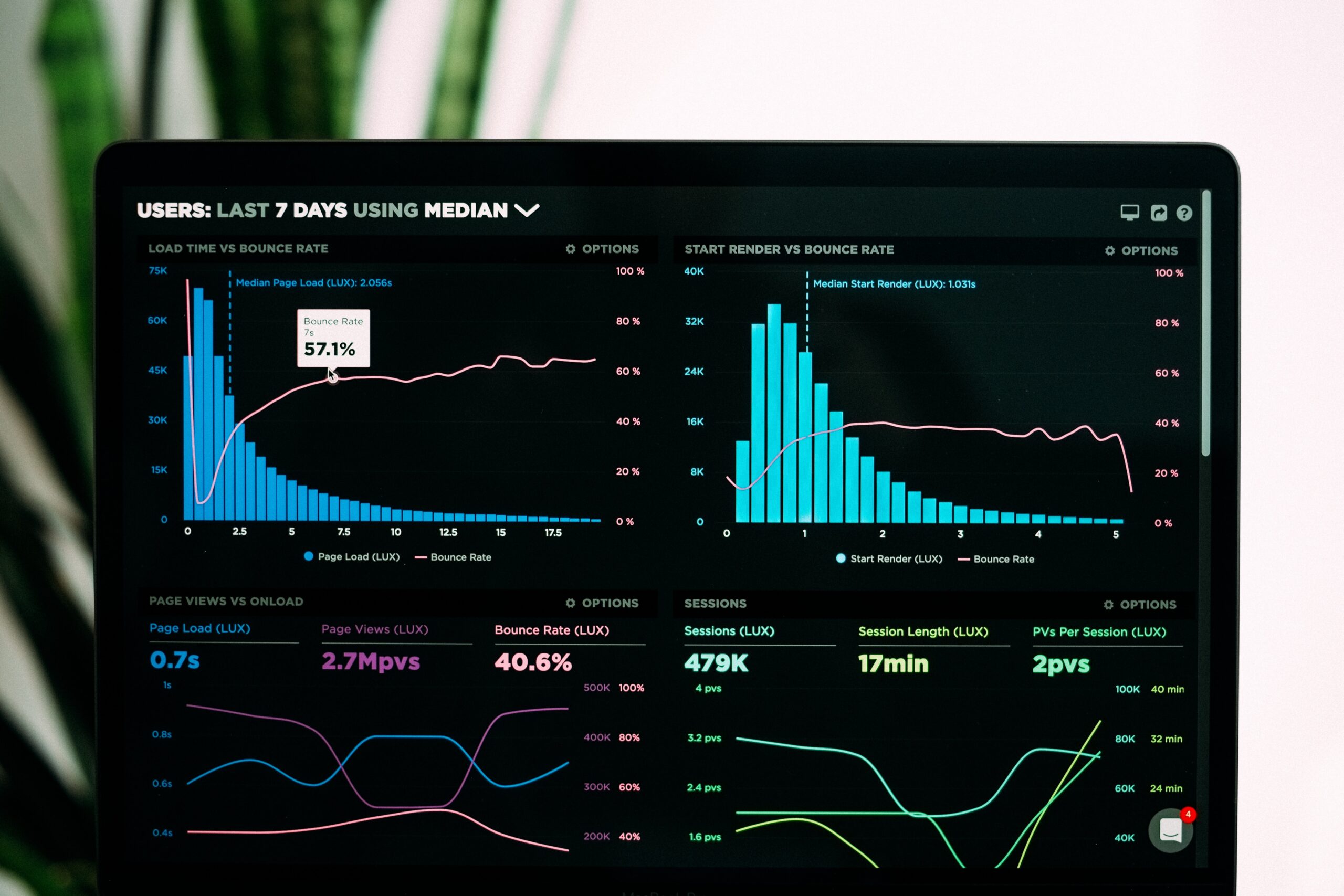

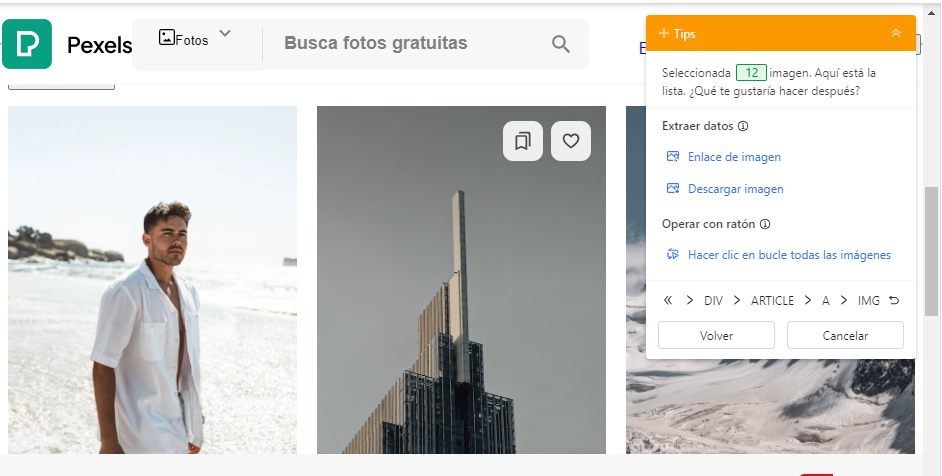

Los hipervínculos son URL en las que se puede hacer clic y que abren nuevas páginas o dirigen a nuevos sitios web. Cuando se obtienen URLs, se puede acceder y descargar el archivo o imagen correspondiente a través de estos enlaces. Al raspar enlaces con Octoparse, sólo tiene que hacer clic en los datos de destino y seleccionar Enlace en el panel Sugerencias. Además, si hace clic en las imágenes de la página y selecciona URL de la imagen en el panel de sugerencias, podrá extraer sus enlaces. Además de extraer enlaces, Octoparse puede extraer varios elementos de páginas web. Independientemente de si necesita texto o HTML, puede configurar un scraper en sencillos pasos utilizando Octoparse.

TOP 2: Apify

Apify es una plataforma para el web scraping. Los usuarios pueden encontrar herramientas ya hechas y plantillas de código para extraer datos de sitios web. Muchos extractores de enlaces son diseñados y subidos por los desarrolladores disponibles en Apify, y la mayoría de ellos son fáciles de usar y le permiten gestionar las tareas de web scraping sin grandes conocimientos de programación. Sin embargo, si tienes cero experiencia en codificación, la curva de aprendizaje puede ser empinada.

TOP 3: BrightData

Bright Data es una empresa que ofrece servicios de recopilación de datos web a empresas B2B. Proporciona a los usuarios varias herramientas y APIs para el web scraping con diversos propósitos. URL Scraper en Bright Data está preestablecido, y puede aplicarlo para recopilar URL de sitios de comercio electrónico, medios sociales, sitios web de bienes raíces y más. Pero preste atención al coste. Utilizar los servicios de Bright Data puede ser costoso si tiene necesidades de raspado intensivas o de gran volumen.

TOP 4: WebHarvy

WebHarvy es un software de raspado web de apuntar y hacer clic para que los usuarios extraigan datos web, incluidas las URL, con facilidad. Cuando se raspa URLs usando WebHarvy, puede utilizar su preestablecido Expresión Regular para obtener enlaces de HTML en lugar de escribir uno por sí mismo.

👉 Extensión de Chrome

TOP 5: Link Grabber

Link Grabber es un extractor, especialmente para hipervínculos en páginas HTML. Como es una extensión de Chrome, es ligera y fácil de usar. También puede filtrar enlaces por coincidencia de subcadena y agrupar enlaces por dominio, por lo que puede ahorrar tiempo para limpiar los datos raspados. Pero sólo puede extraer enlaces en sitios web, si necesitas más datos como texto e imágenes, probablemente no sea la mejor opción.

TOP 6: Link Gopher

Esta es otra herramienta ligera con un enfoque en la extracción de enlaces. Puede extraer todos los enlaces de una página web, incluidos los enlaces incrustados, ordenarlos, eliminar duplicados y mostrarlos en una nueva pestaña para copiar y pegar. Utilizar esta herramienta para extraer enlaces sólo requiere un clic para elegir la opción Extraer y, a continuación, podrás obtener las URL que desees. Pero como se mencionó, no se puede exportar raspado en archivos directamente, pero copiar y pegar en otros sistemas por sí mismo.

TOP 7: Link Klipper

Link Klipper es uno de los extractores de enlaces más populares de la Chrome Web Store. Es simple pero potente y te ayuda a extraer todos los enlaces de una página web y exportarlos a un archivo. Puedes personalizar un área de la página web y extraer todos los enlaces de esta área en función de tus necesidades. Sin embargo, con esta extensión sólo puede exportar todos los datos raspados como archivo CSV. Si necesita almacenar los datos en otros formatos para su análisis, tendrá que dedicar más tiempo a convertir el formato de CSV.

👉 Solución de Codificación

TOP 8: Beautiful Soup (Python)

Beautiful Soup es una popular biblioteca de Python para extraer datos de archivos HTML y XML. Puede manejar bien HTML mal formateado y proporciona una API sencilla e intuitiva para navegar y extraer datos de documentos HTML. Si estás familiarizado con la codificación, puede ser un método flexible y eficaz. Aquí está el código de ejemplo que muestra cómo Beautiful Soup raspa enlaces de un sitio web.

TOP 9: Scrapy (Python)

Scrapy es un potente y flexible framework de código abierto para el rastreo y el scraping web escrito en Python. En Scrapy encontrará un completo conjunto de herramientas para la extracción de datos, incluidos enlaces. Una de las ventajas más significativas de Scrapy es que está bien adaptado para tareas de scraping a gran escala, soportando el crawling distribuido y manejando escenarios complejos de forma efectiva. A continuación se muestra el código de ejemplo para la extracción de enlaces utilizando Scrapy.

TOP 10: Selenium (Varios Idiomas)

Selenium es conocida como una herramienta de automatización web utilizada para probar aplicaciones. Pero también se puede utilizar para tareas de web scraping. En comparación con otras librerías de Python, Selenium visualiza el proceso de scraping, lo que facilita la depuración y verificación de los enlaces extraídos. Pero, en términos de velocidad de scraping, Selenium puede ser relativamente más lento comparado con Beautiful Soup o Scrapy, especialmente para tareas de scraping a gran escala.

Conclusión

La extracción de enlaces desempeña un papel esencial en los estudios de mercado. Permite recopilar datos para la investigación, el análisis SEO, la generación de clientes potenciales, etc. Además, respalda los estudios de mercado y la supervisión de marcas que contribuyen a las estrategias de marketing y a los esfuerzos de cumplimiento. Independientemente del sector en el que se encuentre, puede beneficiarse del uso de extractores de enlaces. Espero que pueda encontrar las herramientas de extracción de enlaces adecuadas en este post e impulsar su negocio con la ayuda de la extracción web.

Convetir datos de sitios web en Excel, CSV, Google Sheets y base de datos directamente.

Scrapear datos fácilmente con funciones de Auto-Detectar, sin codificación.

Plantillas de crawler preestablecidas para sitios web populares para obtener datos en clics.

Nunca se bloquee con proxies IP y API avanzada.

Servicio en la Nube para programar la recopilación de datos en cualquier momento que desee.